Opp(Obstacl Path Planner) TensorFlow 2.16.2 Lite C++ library build.

TensorFlow 2.16.2 Lite C++ library build. の続き。

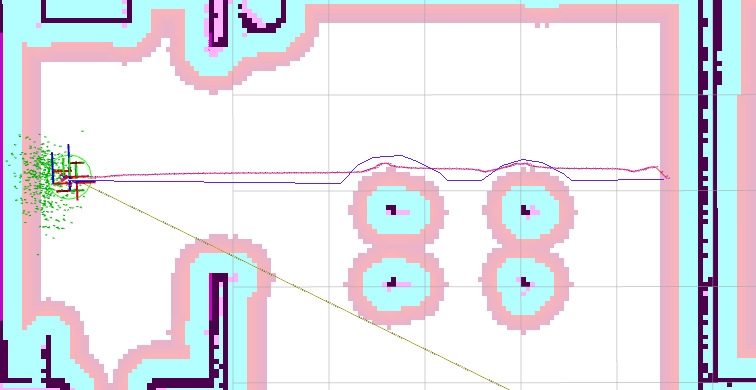

前回に続いて、今回は、本題の ROS2 自作 Turtlebot3 による 草刈りロボット開発。#9 LSTM で経路計画をする。

で作成した学習モデルを、C++ 及び ROS2 C++ で簡単に predict できるライブラリーを作成する。

環境

PC and Orange Pi 5 Armibian Jummy

Ubuntu 22.04

Tensorflow 12.6.2

ROS2 Humble

最新は、

Ubuntu 24.04

Tensorflow 2.18.0

ROS2 Jazzy

/home/nishi --> /home/your-id に変えとうせ。

1. ROS2 のプログラムから使える、opp_tflie.cpp を作成する。

ROS2 global costamap の一部を、cv::Mat に取り込んで、class Opp_Tflite に渡せば、

opp_with_lstm または、opp_with_transformer のモデルで、predict して、その結果を、

std::vector<u_int8_t> y_pred に返してくれるもので、これをライブラリとして使えるようにする。

1.1 ライブラリ libopp_tflite.a のビルド。

$ make -fMakefile-Archive-opp_tflite

$ make -fMakefile-Archive-opp_tflite install

$ make -fMakefile-Archive-opp_tflite clean

1.2 CMakeLists.txt で、

find_package(Tflite REQUIRED)

find_package(Opp_tflite REQUIRED)

をすれば、同じく簡単にリンケージができるようにします。

cmake/FindOpp_tflite.cmake