おんちゃんも ChatGTP を試してみた。

遅ればせながら、おんちゃんも ChatGTP を試してみた。

試すなら、本家 OpenAI の 無料版 ChatGTP がやはり、断然良い。

https://openai.com/ja-JP/chatgpt/overview/

Google で以前検索して、出てきたサイトをいくつか試してみたが、なんか違うみたいだと感じて、しばらく忘れていたが、

本家、OpenAI の 無料版 ChatGTP にたどり着いたので、再度試してみた。

やっぱり、本家の、ChatGTP は、使い良い。さすがじゃ!!

Google のキーワード検索と違って、文章で聞きたいことを問い合わせできる。

また、出てくる解答も、本家 ChatGTP は、結構、良い。

もっと早くに、本家のOpenAI の 無料版 ChatGTP を使っておけばよかった!!

Quectel LG290P と言う、 クワッドチャンネルの 受信機が出ているみたいじゃ。

スペックの記載に、さらっと、L6 受信とある。

おんちゃんの素朴な疑問。

Quectel LG290P は、みちびき L6 受信ができるのか。

Google の AI の回答だと、

検索キーワード:LG290P L6 みちびき

回答:

LG290P L6は、3周波GNSSアンテナに、みちびきL6/L1S補強信号に対応した受信チップを内蔵した一体型のGNSSユニットです。SBAS測位やRTK測位に加え、みちびきのCLAS(センチメータ級測位補強サービス)とSLAS(サブメータ級測位補強サービス)を利用した測位が可能です。

が返ってきた。ならば、Quectel LG290P 単体+ L5,L6アンテナ で、みちびきの 7[cm] 級の

精度が出るということなの?

検索キーワード: LG290P みちびき L6 CLAS

の方が、もっと詳しく出てくる。

中華の製品には懲りているが、aliexpress だと、アンテナ込みで、20,000円 以下で手に入る。

これは、試してみる価値があるのかも。

注) aliexpress で購入する時は、あまりにも安い店は使わないほうが良い。他店と比べて相応な値段を選ぶべし。by おんちゃんの戒め。

あと、商品画像に、ショップのロゴを入れていて、店の評価が多い点も判断材料になると思う。

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#13 robot_localization ukf を試してみる。

robot_localization の ukf_localization_node を使って、

foxbot_core3 for ros2 を走行させてみる。

ロボット走行には、UKF: Unscented Kalman Filter が向いているそうなので、試してみた。

Ekf 版の launch.py があるので、その中の、ekf_localization_node 向け を ukf_localization_node 向けに変えるだけで、OK だった。

とおもったが、勘違いで、ukf用のパラメータの設定が必要じゃ。

今は、まだ動作してないぞね!!

Quectel LG290P を試す方が先だから、この記事は、少し保留じゃ。by nishi 2025.7.14

環境:

実機ロボット:foxbot_core3 for ros2

OrangePi 5 and Armbian 24.04

OAK-D Lite depth Camera

ROS2 Jazzy Navigation2

Launch: OAK-D Lite Depth Camera , GPS navsat_transform_node and ukf_node

foxbot_nav2_oak-d_depth_gps_ukf.launch.py

C++ 自動走行プログラム:multi_goals4_nav2.launch.py

高知県土佐市の笑えないなんちゃって行政 2025

土佐市の行政の本当の行いを綴る!!

土佐市の一職員の規範意識のなさは、決して今に始まったことではない。連綿と受け継がれる黒歴史。

高知県のみな様、R5年 5-6月の 土佐市 "南風(まぜ)" の騒動で、全国規模で、高知県の評価を下げてしまった事を、土佐市の一市民として、こころよりお詫びします。

また全国の皆様、土佐市の市民は、市役所とちがって、田舎の普通のよい人ばかりです。多くの市民が、なんにも関わっていない事柄で、

全国規模で悪評がひろまってしまった事を、本当に残念に思っています。

機会があれば、広い太平洋の青い海を観にいらしてください。

さて、ここでは、土佐市行政の笑えない部分を綴っていこうかと思います。

そうすることで、土佐市の行政が自ら反省をし、良くなっていってくれる事を願います。

土佐市の板原市長がだんまりを決め込んで、市民が忘れてしまうの待っているようなので、

市民が決して忘れることのないように、YouTube のリンクをはっておくぞね。!!

【独自】高知・土佐のカフェ"炎上"騒動 トラブル退去へ「寂しい思い」【詳細版】【知ってもっと】(2023年9月18日)

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#12 床が高低差がある場所での走行。

環境:

実機ロボット:foxbot_core3 for ros2

OrangePi 5 and Armbian 24.04

OAK-D Lite depth Camera

ROS2 Jazzy Navigation2

Launch: OAK-D Lite Depth Camera and Rtabmap_ros による、Active SLAM

rtabmap_oak-d_rgb_depth.launch.py

C++ 自動走行プログラム:multi_goals4_nav2.launch.py

BNO086 DMP でなんとか、走行できるようになったので、

Rtabmap_ros の 2D で、床が高低差がある場所でロボットを走行させて、2D Mapping が精度よく取れるかためしてみた。

おんちゃんの部屋は、畳で、床の高さが一定でない。以前は、それでも、そのままRtabmap_ros の 2D Mapping を行っていたが、

なんとなく、高低差が気になりだした。

ずっと以前も試したが、BNO086 DMP で安定して IMU が取れだしたので、再度、IMU の Pitch を使って、床の高さを使ってみようと思う。

2D Rtabmap_ros でも、ロボットの tf-basefoot_print の pose.pose.position.z に、高低値を入れてみると、一応加味して、動作するみたい。

ここで、出てくるのは、あくまでも 2D Mapがでてくる。

3D Map は必要ないので、これで十分じゃ。

ただし、どこまで正確に、pose.pose.position.z を出せるかがもんだいじゃが。

注) RTK-GNSS(GPS) を使う場合、RTK-GNSS(GPS) を使って、予め Map 作成すれば良いので、Rtabmap_ros 自体出番がないのだが。

中華製の BNO086 に懲りたので、正規版の BNO086 を購入して、DMPを試すことにした。

Mouser、DigiKey だと、6,000円台で手に入るので、正規版を購入して試すことにした。

Mouser で購入した、正規版が届いたので、早速、テストとしたぞね。

突然のノイズも出なくて、OKだった。

やはり、正規版は、いいぞね。

自作 Turtlebot3(foxbot_core3_r2) で、早速走行テストじゃ。

rtabmap_ros_my/launch/rtabmap_oak-d_rgb_depth.launch.py

で、foxbot_cor3_r2 を、C++ プログラムで、部屋の中を自動走行させて、

Rtabmap_ros で、Map 作成させてみた。

久しぶりに完走できました。by nishi 2025.6.20

ICM-42688 Madgwick、Mahony 6軸 Fusion を試す。

ポンコツの ICM-20948 DMP を諦めて、BNO086 を試して、結局ICM-20948 Madgwick 6軸 Fusion になった。 の続きです。

ICM-42688 Acc + Gyro Mahony と Madgwick 6軸フュージョンを試す。

ICM-20948 より格段にノイズが低い、ICM-42688 を使って、Mahony と Madgwick 6軸フュージョンで、

実用に耐えうるノンドリフトの性能が実現できるか確認する。

目標は、ROS2 Rtabmap_ros の Depth camera による、Active SLAM で、毎回キレイに Mapが作成できるか確認する。

開発環境

Platform I/O IDE

ESP32 Arduino

ICM-42688 Acc 、Gyro : 500[Hz]

I2C

実機での確認

foxbot_core3 for ros2 に乗っけて、動作確認をする。

Arduino のライブラリーは、下記を使う。

finani / ICM42688

残念ながら、tdk-invn-oss のオリジナルでは無いみたい。

ただし、ICM42670P のオリジナル、motion.arduino.ICM42670P より、使い良いかも知れない。

SparkFun の ICM-20948 Arduino ライブラリー版に似ているので、Acc + Gyro 同時取得が、簡単のようだ。

ありがとう、finani

1. ソースダウンロード

$ cd ~/Auduino/lib-foxbot_core3_r2

$ git clone https://github.com/finani/ICM42688.git

ICM42688/src/ICM42688.cpp 、 ICM42688.h をそれぞれ、

ICM_42688.cpp 、 ICM_42688.h に名称を替えて、下記に修正。

注) 自分のソースが、ICM42688.cpp 、 ICM42688.h を使っているので!!

ICM-20948 と BNO086 のコンビネーションで、Mahony の 9軸Fushion を試してみる。

MotionCal で、ICM-20948 の Magnetoをキャリブレーションするのは至難の業だと思うので、 ICM-20948 Acc 、Gyro と

BNO086 MagCali(キャリブレーションされた Magneto) を、Mahony または、 Madgwick に通して、9軸Fushion できないか試してみる。

ICM-20948 Acc 、Gyro : 400 - 500[Hz]

BNO086 MagCali: 100[Hz]

でサンプリングして、Mahony または、 Madgwick の 9軸Fushion をしてみる。

MagCali 100[Hz] なので、MagCali が取れていないときは、mx=my=mz=0.0 として、自動的に 6軸Fushion となるようにする。

Madgwick も、Acc、Gyro を 500[Hz] 辺りで与えると、ブルブルも気にならなくなる。

この組み合わせだと、ドリフトがでなくなるのでは? ただし、向きの精度は、最終的には、BNO086 MagCali の精度と同じにるのでは?

ポンコツの ICM-20948 DMP を諦めて、BNO086 を試して、結局ICM-20948 Madgwick 6軸 Fusion になった。

注) ICM-20948 DMP がポンコツと言うわけでは無いみたい、SparkFun のライブラリーに入っている、icm20948_img.dmp3a.h が 1.1.0 で、古いのが問題みたい。

最新の、1.1.1 版を使えば、OK とおもったが、やはりだめだった。やはりポンコツか!!

結局は、ICM-20948 Madgwick 6軸 Fusion で、なんとか使えるのが実現できたの話。

最後まで、目を通しとうせ。by nishi 2025.5.25

SparkFun ICM-20948 Arduino で、 DMP Fusion 9軸 がやっとOKになった。 の続きです。

1. 中華製の安い BNO086 があったので、購入して、DMP 9 を試してみる事にした。

当初、SparkFun の Arduino Library で試していたが、これがまるっきり使えない。

やはり、正規版の石でないとだめなのかと思ったが、

Adafruit の Arduino Library があったので、こちらを試してみた。

adafruit / Adafruit_BNO08x

こちらだと、安定して動くみたい。

しかも、こちらだと、RST、INT ピン接続が必要ないみたい。

もしかしたら、Chip のfirmware のバージョンの新旧の違いがあるのかも知れない。

中華製の Chip の firmware のバージョンが 旧で、それが、Adafruit の Arduino Library と一致したのかも?

注) ESP32 の場合、Adafruit の I2C Arduino Library が相性が悪いことが判明、逆にSparkFun ICM-20948 Arduino のほうが相性が良い。

SparkFun ICM-20948 Arduino で、 DMP Fusion 9軸 がやっとOKになった。 で実施した、Rviz2の長期テストでは、問題ないみたい。

あとは、草刈りロボットの実機で使ってみて、評価しないといかんぞね!!

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#11 ロボットの走行方向がずれる。

SBC: Orange pi 5 Armbian Ubuntu 24.04

ROS2: Jazzy

Jazzy 版にして、rtabmap_ros_my/foxbot_nav2_oak-d_depth_gps.launch.py で、自作 Turtlebot3 を動かしたら、最近どうも、ロボットの向きがずれる気がする。

Rviz2 の画面上は、ロボットは、目的地にちゃんと到達しているが、実機のロボットは、結構ずれた位置に行ってしまう。

1. EKF の設定が変わったのかと、いろいりためしていたが、

どうやら、原因は、 IMU ボードの取り付け向きが、ロボットの進行方向にから少しずれているみたいじゃ。

今まで、あまり気にしていなかったが、もしかしたら、DMP 9 の場合の、IMU のキャリブレーションを取っ払ってしまっていたかも知れない。

もとい、これは、単純に、IMU ボードの向きを正すしかない。

あと、ICM-20948 の接続ケーブルの接触が、時々不良になるみたい。そのせいで、急に Device ID が取れなくて、初期化処理でずっこける。

以前は、電源電圧が低下している所為と思っていたが、単純に、接触不良みたいじゃ。

ROS2 Jazzy + Turtlebot4 + Gazebo Ionic warehouse Simulation.

Ubuntu Mate 24.04 にしてみたら、Gazebo が、新しくなっていて、今まで使っていた、

Hose World が使えなくで、困っていたら、

パッケージを新しくすると、Turtlebot4 + Gazebo Ionic warehouse Simulation がかんたんに使えた。

All In One みたい。

参考は、

TurtleBot3 + Gazebo + Navigation2 (ROS 2 Jazzy)

ros-navigation/nav2_minimal_turtlebot_simulation

1. git clone

$ cd ~/colcon_ws-jazzy/src

$ git clone -b jazzy https://github.com/ros-navigation/nav2_minimal_turtlebot_simulation.git

$ cd ..

$ rosdep update --rosdistro=${ROS_DISTRO} && rosdep install --from-path src/nav2_minimal_turtlebot_simulation -r -s

必要な、パッケージが一覧ででてくるので、

$ sudo apt install xxxxx

ソースビルドして、

2. build

$ colcon build --symlink-install --cmake-args -DCMAKE_BUILD_TYPE=Release [--packages-select nav2_minimal_turtlebot_simulation]

$ . install/setup.bash

3. run

$ ros2 launch nav2_bringup tb4_simulation_launch.py headless:=False

で一応、Gazebo 画面と、Rviz2 画面は、でてきた。

しかし、Rviz2 画面で、Navigation の操作ができない。

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#10 走行開始時のロボットの向き。

--- ros2 nav2_gps_waypoint_follower_demo autonomous は、できるか検討する。 ---

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#9 LSTM で経路計画をする。

が出来たので、自分の部屋で、実機を Auto Mower で走らせている。

その中で、気になりだしたのが、ロボットの開始時の向きのズレが気になる。

Auto Mower で走行するときは、予め作成した、Static Map をベースに走行している。

この時、Static Map 作成時の、ロボットの向きと、 Auto Mower 走行時のロボットの向きがずれていると、具合が悪い。

1度ずれていると、数十メートルそうこうすると、かなりのズレが生じてしまう。

やはり、みちびき等の GNSS でロボットの位置を補正するしかないのかも。

Opp(Obstacl Path Planner) TensorFlow 2.16.2 Lite C++ library build.

TensorFlow 2.16.2 Lite C++ library build. の続き。

前回に続いて、今回は、本題の ROS2 自作 Turtlebot3 による 草刈りロボット開発。#9 LSTM で経路計画をする。

で作成した学習モデルを、C++ 及び ROS2 C++ で簡単に predict できるライブラリーを作成する。

環境

PC and Orange Pi 5 Armibian Jummy

Ubuntu 22.04

Tensorflow 12.6.2

ROS2 Humble

最新は、

Ubuntu 24.04

Tensorflow 2.18.0

ROS2 Jazzy

/home/nishi --> /home/your-id に変えとうせ。

1. ROS2 のプログラムから使える、opp_tflie.cpp を作成する。

ROS2 global costamap の一部を、cv::Mat に取り込んで、class Opp_Tflite に渡せば、

opp_with_lstm または、opp_with_transformer のモデルで、predict して、その結果を、

std::vector<u_int8_t> y_pred に返してくれるもので、これをライブラリとして使えるようにする。

1.1 ライブラリ libopp_tflite.a のビルド。

$ make -fMakefile-Archive-opp_tflite

$ make -fMakefile-Archive-opp_tflite install

$ make -fMakefile-Archive-opp_tflite clean

1.2 CMakeLists.txt で、

find_package(Tflite REQUIRED)

find_package(Opp_tflite REQUIRED)

をすれば、同じく簡単にリンケージができるようにします。

cmake/FindOpp_tflite.cmake

TensorFlow 2.16.2 Lite C++ library build.

TensorFlow 2.16.2 Lite C++ library をソースからビルドしてみた。

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#9 LSTM で経路計画をする。 で、Tensorflow Lite 用の a.model.tflite が出来たので、C++ から実行する事になるので、試してみた。

ソースのダウンロードは、TensorFlow 2.16.2 C++ library build と同じなので、そちらを参考にしてください。

また、 $ ./configure も行ってください。

注) llvm-17 、clang-17 が必要です。

Ubuntu 24.04 では、 llvm-18 がディフォルトなので、要注意!!

環境:

PC and Orange Pi 5 Armibian Jummy

Ubuntu 22.04

Tensorflow 12.6.2

Bazel 6.4

最新は、

Ubuntu 24.04

Tensorflow 2.18.0

参考にしたのは、

CMake を使用した TensorFlow Lite の構築

1. build

ソースが、

~local/tensorflow/tensorflow-2.16.2

に展開済みとします。

$ cd ~local/tensorflow/tensorflow-2.16.2

$ mkdir build-nishi

$ cd build-nishi

$ cmake ../tensorflow/lite

$ cmake --build . -j3

注) build-essential が必要。まだの場合は。

$ sudo apt install build-essential

これで、libtensorflow-lite.a が、カレントディレクトリーにできる。

TensorFlow 2.16.2 C++ library build for GPU.

TensorFlow 2.16.2 C++ library build の GPU対応版です。

1. 開発環境

PC: Ubuntu Mate 22.04

Virtual_env

python 3.10.12

bazel 6.4.0

clang-14(llvm-14) <--- NG

clang-17(llvm-17) <--- needed

GPU: GeForce GTX1070 Compute Capability 6.1

GPU 本体のドライバー

nvidia-driver-525

GPUプログラム開発用のライブラリー群

CUDA Toolkit 12.3

cuDNN v8.9.6

Nvidia 提供のライブラリー

TensorRT 8.6.1.6

1.1 ドライバーのインストールから、簡単におさらいする。

i) GPU 本体のドライバーをインストールする。

$ sudo apt install nvidia-driver-525

ii) GPUソフトウエア 開発用に、CUDA 12.3 を使うので、

CUDA Toolkit 12.3 を、Nvidia のサイトからダウンロード&インストールする。

google で、 CUDA Toolkit 12.3 を検索すると出てくると思う。

cuda-12-3-0-download-archive

Linux -> x86_64 -> Ubuntu -> 22.04 -> deb(network)

> Base Installer の欄を実行する。

/usr/local/cuda-12.3/ へ、インストールされる。

include/cuda.h

bin/nvcc <-- nvcc もある。

iii) cuDNN v8.9.6 for CUDA 12.x をダウンロード&インストールする。

注) $ sudo apt list 2>/dev/null | grep cudnn で、出てくれば、そちらがかんたん。

やり方は、上記と同じ。

cudnn-archive

-> Local Installer for Ubuntu22.04 x86_64 (Deb)

libcudnn8, libcudnn8-dev

インストール先は、/usr になる。

$ sudo dpkg -L libcudnn8-dev

/usr/include/cudnn.h

/usr/include/cudnn_version.h

iv) TensorRT 8.6.1.6 のインストール。

本当は、使いたくないが、configure で、指定しないと、うまくいかないので、使う。

注) $ sudo apt list 2>/dev/null | grep tensorrt で、出てくれば、そちらがかんたん。

TensorRT-8.6.1.6.Linux.x86_64-gnu.cuda-12.0.tar.gz を、google で探して、

~/usr/local/share/ 下で展開しました。

/home/nishi/usr/local/share/TensorRT-8.6.1.6

注) ubuntu 24.04 の場合 の ii) - iv)

tensorflow 2.18.0 になるみたい。

NVIDIA Driver, CUDA, cuDNNのインストールをAPTでサクッと済ませる - Ubuntu Linux が参考になる。

ii) CUDA Toolkit 12.6 以降になる? 12.8 みたい。

CUDA Toolkit 12.8 Downloads

Linux -> x86_64 -> Ubuntu -> 24.04 -> deb(Network)

Base Installer を行う。

$ wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2404/x86_64/cuda-keyring_1.1-1_all.deb

注) 12.6 、 12.8 の場合も同じ。

$ sudo dpkg -i cuda-keyring_1.1-1_all.deb

$ sudo apt-get update

$ sudo apt-get -y install cuda-toolkit-12-8

iii) cudnn9.x.x になるのか?

$ sudo apt install cudnn9-cuda-12

iv) Tensor RT

$ sudo apt install tensorrt-dev

tensorrt-libs も必要か?

実際の中身は、一緒にインストールされる、付随パッケージの中にあるみたい。

$ sudo dpkg -L libnvinfer-headers-dev

/usr/include/x86_64-linux-gnu 下へ、header が入るみたい。

driver-525 への固定。

$ sudo apt-mark hold nvidia-driver-525

も必要か?

v) clang-17(llvm17) のインストール。(必須)

下記を参考にインストールする。

How to install Clang 17 or 16 in Ubuntu 22.04 | 20.04

$ wget https://apt.llvm.org/llvm.sh

$ chmod u+x llvm.sh

$ sudo ./llvm.sh 17

$ sudo apt list --installed >/dev/null | grep clang

$ dpkg -L clang-17

remove

$ sudo apt remove --purge clang-17

$ sudo apt autoremove --purge

もしかしたら、下記も必要かも?

$ sudo dpkg-reconfigure clang-14

下記は、参考にしたページの記載です。

$ sudo rm /etc/apt/sources.list.d/archive_uri-http_apt_llvm_org_*.list

sudo rm /etc/apt/trusted.gpg.d/apt.llvm.org.asc

TensorFlow 2.16.2 C++ library build

TensorFlow 2.16.2 C++ library をソースからビルドしてみた。

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#9 LSTM で経路計画をする。 で、最終的には、C++ から実行する事になるので、試してみた。

参考にしたのは、

ソースからビルドする

Ubuntu20.04 LTS上で、TensorFlow 2.3.1をソースからビルドし、C++言語の共有ライブラリを作成する

tensorflow 2.0 c++ apiをcmakeで利用する

1. 開発環境

PC: Ubuntu Mate 22.04

Virtual_env

python 3.10.12

bazel 6.4.0

llvm-14

1.1

PC: Ubuntu Mate 24.04

Tensorflow 2.18.0

Virtual_env

python 3.12.3

bazel 6.4.0

llvm-17 、clang-17、 clangd-17

注) aarch64(arm64) のときは、gcc を使う。

追加パッケージのインストール。

下記エラーが出たので、

https://stackoverflow.com/questions/16661167/fatal-error-when-compiling-llvm-clang-cstddef-file-not-found より、

$ sudo apt install libstdc++-12-dev

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#9 LSTM で経路計画をする。

--- ROS2 ロボット自律走行の経路計画の補助に、機械学習(Transformer、LSTM)を使う。 ----

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#8 Transformer で経路計画をする。 の続きです。

Transformer で、学習データ 1000個作って、学習させてみたが、1000個では、まるっきり足りないようで、 train loss = 0.7 を切らない。

業を煮やして、それならと、 Speech to text の LSTM を同じ様に学習させてみました。

こちらは。1000件ほどのデータで、うまく学習できました。

これは、凄い!!

こんなにうまく行くとは、予想できませんでした。

本当に、うまく予測できているのか、今も、半信半疑です。

余りの感激に、涙がちょちょでるぞね!!

github に公開しました。

tosa-no-onchan/opp_with_lstm

1. 開発環境

PC: Ubuntu Mate 22.04

Python 3.10.12

virtual_env

tensorflow 2.16.2

keras 3.6.0

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#8 Transformer で経路計画をする。

--- ROS2 ロボット自律走行の経路計画の補助に、機械学習(Transformer、LSTM)を使う。 ----

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#6 Nav2 Planner を替えてみる で、ThetaStarPlanner を使って、Auto Mower 時の走行の直進性の改善がみられた。

しかし、まだおんちゃんが望む直進性能には、足りない。

そこで、ThetaStarPlanner の経路プランの一部補正として、機械学習が使えないか、無い知恵を絞って、考えてみた。

1. 概要

結論を先に言ってしまえば、経路プランに、Transformer、Lstm による、Speech To Text モデルのロジックを使えないだろうか? と言う話じゃ。

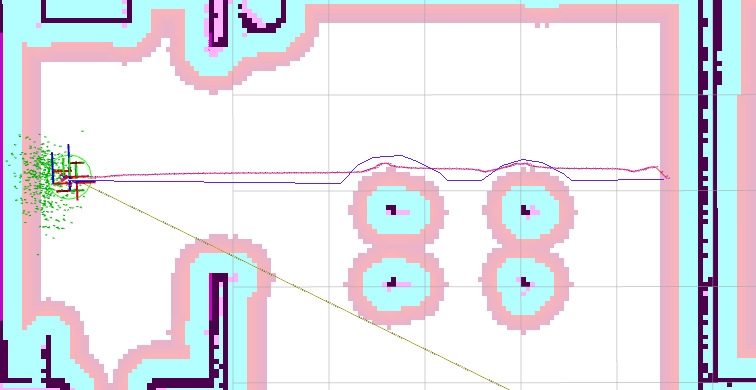

下の画像だと、赤線の経路を、青線の様にしたい。

障害物の手前まで真っ直ぐ進んで、障害物をなぞるように進んで、再度、スタートとストップの直線上に戻る、走行が欲しい。

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#7 障害物からの脱出に機械学習を使う。

---- Auto Mower で、障害物に囲まれた際の脱出方向の算出に、機械学習の画像分類 (Image Classify) を使ってみる。-----

Auto Mower で、ロボットを動かして、目的地に到達させた場合に、障害物に近づき過ぎる場合がある。

そうすると、navigation2 で、その場所から抜け出せずに、エラー終了してしまう。

これを、防ぐ為に、static map 上で、障害物に囲まれた際に、脱出方向を計算して、cmd_vel モードで、ロボットを少し遠ざけている。

現状は、ProControl::obstacle_escape() で処理を行っています。

処理概要は、

Static Map から、ロボットの周りを、OpenCV の cv::Mat に取りこんで、8方向のMaskを用意して、Mask と AND を取って、障害物の Dot を取得した後、

それぞれの方向で、一番障害物が少ない(Dot が少ない)方向に、cmd_vel を使って動かす。

注) 今は、Local Cost Map(static_layer + obstacle_layer) を、resolution: 0.01 の解像度で使っています。

これって、画像(2値画像か、グレースケール画像)を取りこんで、その画像パーターン(黒い部分が障害物、白が空きスペース)から、8クラス(クラス=方向) に分類する、

Image Classify ではないじゃろか?

Image Classify だったら、Orange Pi 5 の NPUでも使えそうじゃ!!。

少し、試してみないといかん。

ROS2 自作 Turtlebot3 による 草刈りロボット開発。#6 Nav2 Planner を替えてみる。

---- Ros2 Navigation2 Planner を、NavfnPlanner から、ThetaStarPlanner に替えてみた。 ----

nav2.org / tuning を見ていたら、

Planner Plugin Selection

NavFn will typically make broad, sweeping curves; Theta* prefers straight lines and supports them at any angle;

and Smac 2D is essentially a classical A* algorithm with cost-aware penalties.

と記述があったので、

Theta を使えば、少しは、ロボットを直線的に走らせられるのではないか?

と思ったので、早速試してみた。

具体的には、xxx.yaml の中の、

planner_server:

で指定するので、ここを変更すれば良い。